为什么训练数据量少时,会出现过拟合现象?过拟合现象的根源是什么?

为什么训练数据量少时,会出现过拟合现象?过拟合现象的根源是什么?

About

下文面向有一定深度学习背景的人。

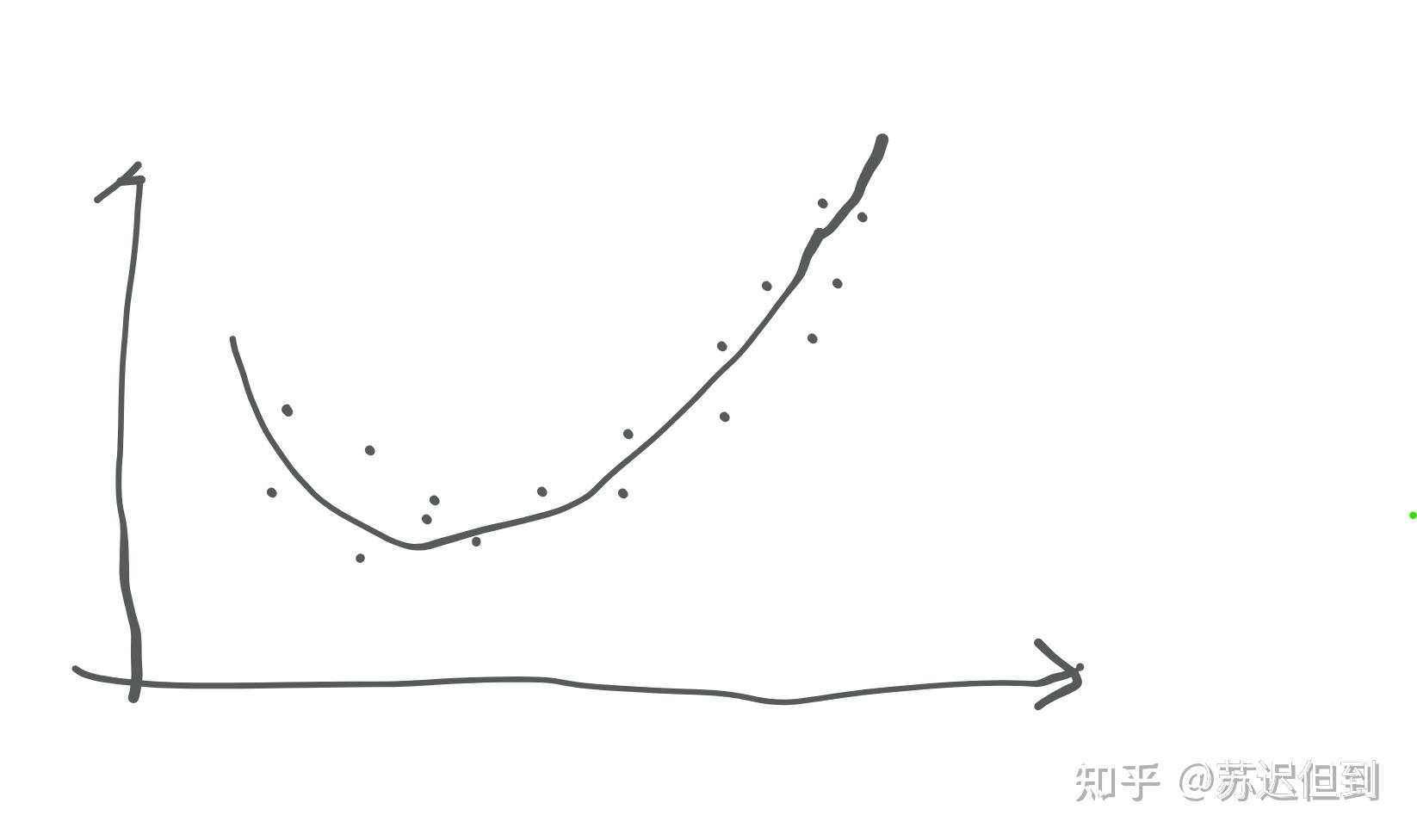

我们要搞清楚神经网络的本质是函数的拟合,且我们的手段是使得拟合出的曲线与样本集的偏差尽可能小。

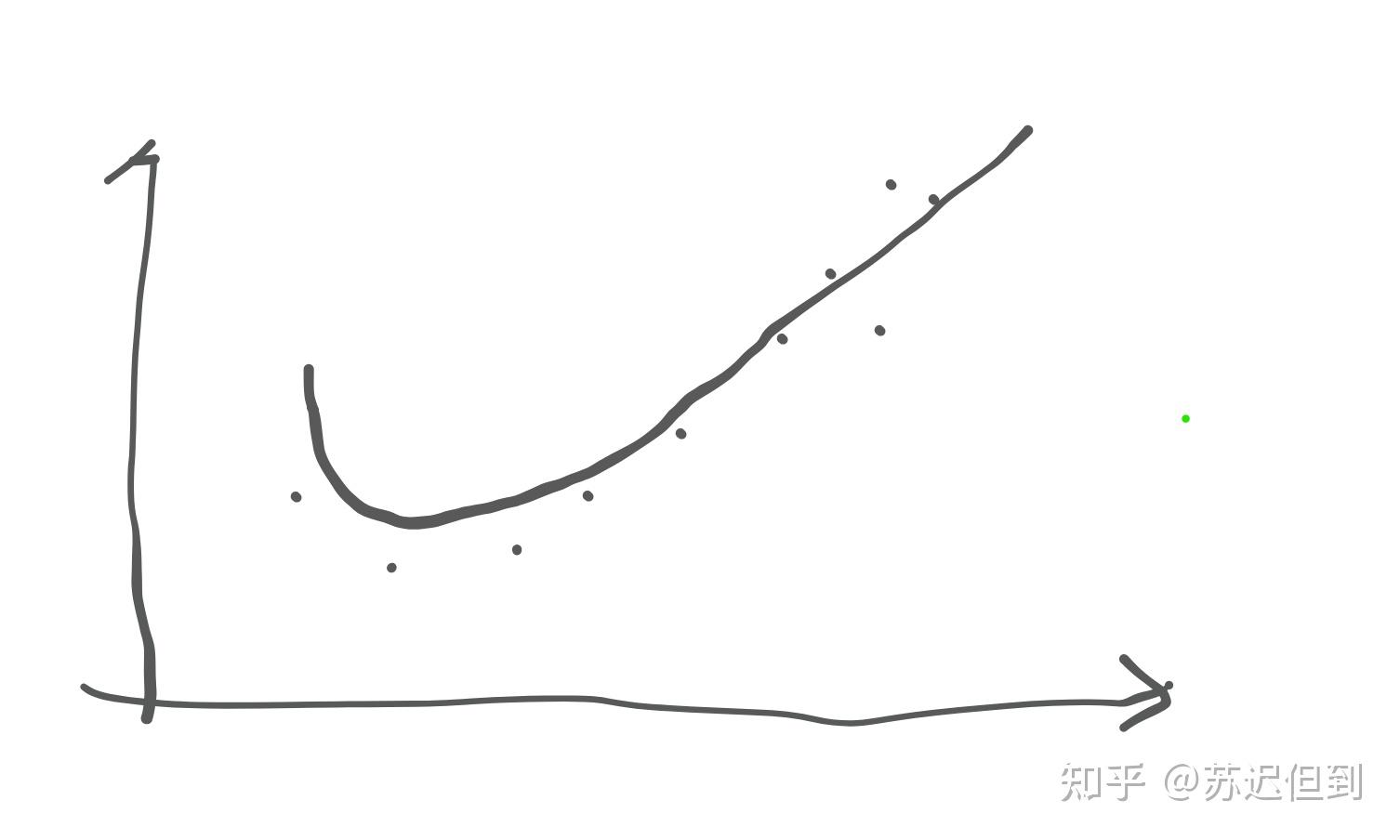

当样本集过小,会导致样本集的采样不均匀,从而生成曲线与真实曲线产生偏差导致了过拟合。

所以根源是样本集的采样不均匀。

而样本集大,就一定意味着采样均匀吗?不是的。

但是我们可以依靠大数定律和概率论来证明样本集越小,越容易产生采样不均匀的事件产生。

我们如果已经知道了最优的预测模型(或者你可以把测试集作为训练集),那么我们只需要用最优预测模型反向挑选从而可以构建一个很小的样本集合,但是却不会产生过拟合。

但是问题是,我们不可能在没有训练完成之前获取最优预测模型,所以我们在初期挑选的时候要尽可能的多采样,避免不均匀。